- Vuoi collaborare con noi?

- redazione@canalecultura.it

A 30 anni dalla nascita, ecco tutti i rischi che corre il world wide web

A cosa serve la cultura? Cronaca di una morte annunciata

11/06/2018

Noi umani sopravviveremo all’intelligenza artificiale?

03/12/2019A 30 anni dalla nascita, ecco tutti i rischi che corre il world wide web

Tecnologia frammentata, filtri, software coperti da copyright. Dal 1989 internet ha fatto molti passi avanti, ma ci sono ostacoli. Parola di Cern, dove tutto è cominciato

Il 12 marzo il world wide web compie 30 anni. Il marzo del 1989 Tim Berners-Lee presentava una proposta di ricerca sui sistemi di gestione delle informazioni, la prima teorizzazione di quello che poi sarebbe diventata l’internet che conosciamo oggi. Quel documento fu presentato allo European Organization For Nuclear Research (Cern) di Ginevra, dove Berners-Lee lavorava e dove si trovava il computer che ospitò il primo server della storia del web.

In 30 anni il web ha preso traiettorie evolutive che sembravano impensabili per chi lo immaginava come un grande ipertesto ed è diventato rapidamente una, se non la principale, piattaforma della società contemporanea, ora gestita da un consorzio, fondato dallo stesso Berners-Lee, il World Wide Web Consortium, con sede al Mit. È però nel centro di ricerca al confine tra Svizzera e Francia che internet ha iniziato a diventare il web, grazie anche alla scelta del Cern di rendere disponibile liberamente il codice della creazione di Berners-Lee, affinché fosse accessibile al numero più alto possibile di persone.

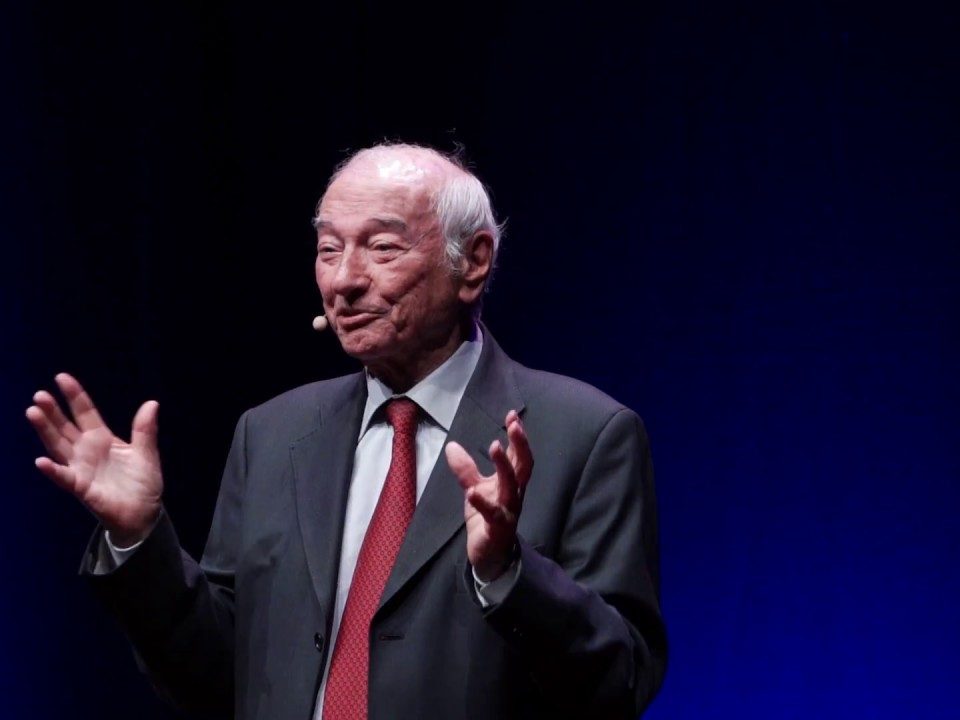

L’informatico del Cern François Flückiger nel 1994 è succeduta a Berners-Lee alla guida del team per lo sviluppo del web al centro di ricerca elvetico, dove ora lavora come Knowledge transfer officer for Information technologies e direttore della sua School of computing, prima di diventarne membro onorario. Incluso nella Internet hall of fame nel 2013, Flückiger è stato uno dei pionieri di internet in Europa ben prima della creazione del web e ha contribuito direttamente allo sviluppo dell’infrastruttura di rete.

Dal Cern ha raccontato a Wired come sta il web oggi e perché i suoi principi sono ancora così centrali per la libertà della rete e della società connessa.

Si celebra il 30esimo compleanno del web. Come valuta il suo stato di salute complessivo? Si ritiene soddisfatto dell’attuale sviluppo?

“Ci sono lati positivi e altri più negativi. Il cambiamento più importante che il web ha portato alla società è probabilmente l’idea che chiunque possa essere non solo un consumatore, ma anche un produttore di informazione e, anche se non spesso quanto vorrei, di conoscenza.

“Non è un aspetto molto conosciuto, ma la primissima idea di web al Cern non era quella di creare un sistema di sola lettura, ma più bilanciato: i nostri primi browser combinavano le funzioni di browsing con quelle di editing. I browser commerciali che sono arrivati successivamente, invece, hanno abbandonato le funzioni di editing. Quella idea è tornata solamente 10 anni dopo, anche se in modo indiretto, con i social network.

“Noi speravamo che si producessero per la maggior parte informazione, idee, o conoscenza. Sfortunatamente la produzione di contenuti per il grande pubblico è oggi per lo più generata tramite i social network, dove le persone parlano per lo più di loro stesse. Anche se in minoranza, la costruzione collettiva di conoscenza resa disponibile liberamente e a portata di mano da Wikipedia o altri siti simili è comunque qualcosa di considerevole.

“Alcuni degli sviluppi meno positivi erano già ipotizzabili nel 1995, quando ho pubblicato il mio libro Understanding Networked Multimedia: temevo che le possibilità di personalizzazione del web avrebbero, e mi cito, ‘ristretto lo spettro degli interessi informativi’. Pertanto, ‘un’eccessiva personalizzazione dell’accesso all’informazione pone i semi per un impoverimento dello spettro degli interessi delle persone’. Inoltre, già allora, avevo il timore che potessero sorgere filtri potenti per l’accesso ai contenuti di intrattenimento o culturali.

“Uno dei peggiori sviluppi, accelerato dall’uso degli smartphone, è la disgregazione della socializzazione non elettronica faccia-a-faccia, specialmente tra i più giovani. Ci sono alcuni punti positivi che mi sorprendono, però: non avevo mai immaginato la tecnologia di ricerca, così veloce ed efficiente, che ha inventato Google. Questo algoritmo è uno dei tre maggiori passi avanti di questa nuova era, le altre due sono l’Ip e il web. Nessuno dei tecnici che conosco aveva nemmeno sognato che qualcosa del genere potesse accadere. Infine, nessuno aveva previsto le altre applicazioni di Google, che sono il risultato della combinazione tra i loro algoritmi e la loro capacità di calcolo colossale”.

In che modo il Cern è impegnato nello sviluppo del web? Su un piano complessivo, pensa che i centri di ricerca e l’accademia siano coinvolti sufficientemente nell’avanzamento di queste tecnologie o quel ruolo è ora nelle mani del settore privato?

“Il Cern è un membro fondatore, e ancora ne fa parte, del W3C, il World Wide Web Consortium. Questo consorzio raggruppa aziende commerciali, i consumatori e anche un ampio spettro di organizzazioni no profit, inclusi enti statali, educativi, accademici e di ricerca. In totale 453 istituzioni fanno parte del W3C e anche le persone singole possono fare domanda. Come per altre organizzazioni multistakeholder, il W3C riflette e soppesa il peso delle prospettive e degli interessi di tutti i suoi membri, ma non si può sostenere che il mondo accademico non abbia influenza.

“Questo modo di sviluppare e promuovere gli standard è diverso da quello che viene utilizzato per internet. La membership del W3C non è gratuita e le primissime bozze sono accessibili solo ai membri. Al contrario, gli standard di internet, realizzati dall’Internet Engineering Task Force (Ietf) si appoggiano a un modello diverso.

“La Ieft è aperta a tutti e non c’è un costo per accedere ad alcun documento, come per contribuire con nuove idee o proposte di miglioramento degli standard esistenti. Questo fa sì che il coinvolgimento dell’accademia sia più semplice, in particolare per gli studenti o gli ingegneri più giovani. Da un po’ di tempo, il Cern non ha svolto un ruolo attivo nello sviluppo del web da un punto di vista tecnologico. Abbiamo creato il web e mantenuto il nostro coinvolgimento fino a quando è stato necessario per completare la nostra missione educativa e raggiungere un livello di funzionalità e stabilità che soddisfacessero i nostri requisiti”.

Il codice originario del web fu rilasciato con una licenza libera, un aspetto che è stato cruciale per la diffusione e la capacità di accesso al web. Pensa che questo principio sia oggi sotto pressione?

“Il software del web, sin dalla sua concettualizzazione, è sempre stato distribuito liberamente dal Cern. Il 30 aprile 1993 il nostro istituto ha pubblicato una dichiarazione per dire che le tre componenti del software – il basic line-mode client, il basic server e la common code library – erano state rese di dominio pubblico. L’obiettivo era quello di insistere ulteriormente sull’apertura e la libertà del software e massimizzarne la diffusione.

“Ad ogni modo, facendo così, il Cern ha rinunciato ai suoi diritti di proprietà intellettuale, dato che questa è la definizione di public domain. Nell’estate del 1994, Tim Berners-Lee ha lasciato il Cern per creare il W3C e mi è stato chiesto di prendere la guida del suo team tecnico qui a Ginevra. A quel tempo il gruppo stava preparando il rilascio della versione 3.0 del server software del Cern e ci siamo accorti che nei precedenti 18 mesi avevamo corso il rischio che delle terze parti se ne appropriassero, dato che non aveva più un proprietario.

“Abbiamo quindi deciso di rendere disponibile la versione 3.0 con una licenza open source, che abbiamo realizzato apposta per questo scopo. Con questa licenza, il Cern mantiene il copyright necessario a proteggere il software dall’appropriazione da parte di terzi, oltre ad assicurarsi l’attribuzione, ma garantisce comunque a chiunque il diritto perpetuo e irrevocabile di usarlo e modificarlo liberamente e senza costi.

“Il 15 novembre 1994 ho mandato questo messaggio alla comunità del web: ‘Queste nuove versioni rimangono liberamente disponibili per l’uso generale e senza costi. L’unico cambiamento è che il materiale distribuito rimane sotto il copyright del Cern. Di conseguenza, una nota dovrà apparire nelle copie’. Nell’autunno del 1994, il movimento free software era diventato più attivo, e più conosciuto al Cern, e i rischi di appropriazione erano più chiaramente dichiarati e descritti, in particolare grazie a Richard Stallman e il Gnu Project. Il rilascio della versione 3.0 è stato anche il primo in open source in assoluto da parte del Cern, ma la palla è ora nelle mani del W3C.

“Da allora, le versioni seguenti del software del web realizzate dal Mit sono sempre state in open source e hanno sempre riprodotto i crediti del Cern. Con l’adozione della policy open source nel 1994, il Cern ha fatto un passo significativo nella direzione di distribuire meglio il suo software. Qualche anno dopo, abbiamo iniziato ad apprezzare non solo il potere ma anche i rischi di una licenza permissiva come quella che avevamo sviluppato nel 1994, che consente ai lavori derivativi di essere distribuiti con una licenza diversa. Il veicolo migliore è il licensing copyleft, come il Gplv3, secondo il quale non si può ridistribuire il software originario o i prodotti derivativi con meno diritti di quelli cui si aveva avuto accesso all’origine.

“Il licensing copyleft è ora la forma più frequente che il Cern utilizza per distribuire il suo software e il movimento per il free software è ancora estremamente attivo in tutto il mondo. L’Unione europea difende la filosofia di condivisione delle licenze copyleft, in particolare per le amministrazioni pubbliche”.

Una percentuale importante di quello che facciamo online oggi avviene fuori dal web, tramite applicazioni mobile o sistemi chiusi. Esiste un pericolo reale che il web possa diventare obsoleto? Come evitarlo?

“Dobbiamo innanzitutto notare che la maggior parte delle pagine web vengono mostrate in modo diverso sugli smartphone e sui computer, ma sono sempre pagine web, il che ci dimostra come questa tecnologia sia flessibile e capace di adattarsi a strumenti diversi. Il cambiamento più significativo è che molte attività, come la consultazione di un sito dopo una ricerca su Google, non sono più svolte tramite la tecnologia open del web.

“Usiamo applicazioni dedicate che installiamo sugli smartphone e che si basano su tecnologie proprietarie. La conseguenza è la frammentazione della tecnologia, il moltiplicarsi delle applicazioni e delle interfacce, invece che l’unicità e la collaborazione. Qui sta il pericolo: la perdita dell’universalità. Se l’open web venisse sostituito da qualcosa di equivalente o migliore da un punto di vista di funzionalità, e se fosse ancora completamente open, con specifiche note a tutti e funzionante con qualsiasi brand o strumento, come utente non mi preoccuperei. Il problema sorge quando quel modello viene sostituito da una tecnologia proprietaria, che nessuno può implementare perché è segreta o protetta dal copyright.

“Al contrario, quando usiamo i computer, la maggior parte delle nostre attività usa ancora la tecnologia open del web, ma si vede una forte crescita delle applicazioni dedicate, spesso pre-installate. La minaccia, però, non è rivolta solo ai servizi web, ma a tutti i servizi networked. Oggi, chiunque può mandare una mail o fare una telefonata senza utilizzare un meccanismo specifico a seconda del modo in cui il destinatario è connesso. Questo è dovuto al fatto che la tecnologia che supporta i servizi è open. Su internet questo è ancora vero quando si tratta di mandare una mail, ma non quando si tratta di fare una telefonata VoIP, o una call video. Ho poche speranze che si possa evitare questa crescente frammentazione delle comunità di utenti: il processo si potrà però rallentare sviluppando standard aperti in modo più veloce per supportare nuove applicazioni. Dato che è stato ritardato troppo il rilascio di standard open per le video chiamate, lo spazio vuoto è stato riempito da soluzioni proprietarie, che non sono interoperabili”.

La media literacy è un tema molto caldo ultimamente. La retorica sui “nativi digitali” ha forse offuscato la necessità di fornire educazione e formazione sui meccanismi del web, le sue origini e la sua storia. Pensa che le generazioni più giovani sappiano abbastanza su cosa sia il web, quali sono i suoi principi, e perché è così importante?

“Il tema è molto vasto. Cosa sanno i più giovani di cosa stanno facendo esattamente quando usano il web? Gli studi tendono a mostrare che, nella maggior parte dei casi, hanno acquisito del know-how ma ben poca conoscenza. La conoscenza è fatta da concetti fondamentali e fatti su cui è possibile costruire competenze aggiuntive e renderla persistente nel corso del tempo. Inoltre, gli studenti acquisiscono conoscenza, la incorporano nei loro corpus complessivo di educazione e la trasformano.

“Il know-how può essere acquisito in autonomia con pochi prerequisiti. Con l’eccezione delle skill fisiche, come il saper guidare una bici o nuotare, che tendiamo a non perdere, il know-how richiede pratica costante in modo che non venga dimenticato. Infine, e questa è forse la maggiore differenza, la conoscenza può essere trasposta più agilmente in altri ambienti e adattata a problemi diversi. Dato che i più giovani acquisiscono know-how, molti si perdono quando incontrano una difficoltà nuova. L’educazione sui fondamenti del computing e del networking è certamente una soluzione, a cominciare dai curricula dedicati nelle scuole elementari. L’esperienza però dimostra che non sempre funziona, perché molti giovani competenti di computer sono convinti di conoscere già queste cose”.

(Fonte: Philip Di Salvo – Wired)